Es un hecho probado, contrastado, demostrado y reiterado que una secuencia de datos debidamente “torturada” puede utilizarse para justificar cualquier cosa, especialmente en manos políticas. Entre las herramientas de tortura numérica más eficientes destaca la estadística, a menudo ayudada de gráficos engañosos, pero incluso dentro de la estadística existe un concepto que, sin necesidad de gráficas, resulta confuso para mucha gente, el periodo de retorno, la probabilidad que se mide en años.

Caramba, yo pensaba que la probabilidad no tenía unidades, siempre la he visto como un porcentaje.

Es que no tiene unidades. En teoría, el periodo de retorno es un “tiempo medio” asociado a una probabilidad, pero en la práctica (y en la prensa) ambos conceptos se confunden, confundiendo también al lector, ya de paso, que termina pensando que algo con un periodo de retorno de 10 años ocurre siempre cada diez años, cual exacto reloj suizo.

Ah, ¿y no es así?

Pues no, por eso he decidido escribir sobre el tema. Pretendo explicar qué es el periodo de retorno sin utilizar ni una sola fórmula, ni una sola, ¿te interesa leerlo?

Pues no es que me apasione el tema, la verdad. Te doy siete minutos, ni uno más.

Algo es algo. Vamos allá. Supongamos que nos encargan el estudio de un determinado fenómeno independiente (terremoto, precipitación, lo que sea). Lo primero y principal es buscar información fiable, así que revisamos páginas y más páginas polvorientas (o bases de datos informatizadas, en el mejor de los casos) y recopilamos un montón de ocurrencias del fenómeno a lo largo de los años.

¿Es fácil conseguir esos datos?

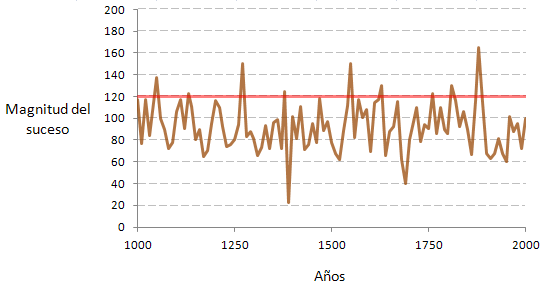

No, ni de coña, normalmente el mayor problema es la ausencia de datos (y no digamos ya fiables), pero como se trata de un ejemplo voy a poner las cosas fáciles y suponer que tenemos datos anuales de los últimos 1.000 años (por números que no sea), y que quedan de esta forma, más o menos.

Como es lógico, el fenómeno se habrá producido con mayor o menor intensidad a lo largo del tiempo, y lo normal es que nos interese saber cuándo ha superado cierto valor máximo (terremoto de magnitud x, lluvia de determinada intensidad, etc) así que nos fijaremos en los valores que superan cierta cota (para este ejemplo, he tomado los que superan la magnitud 120).

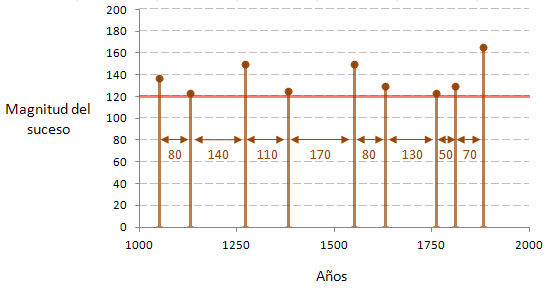

Evidentemente, estas ocurrencias máximas no son periódicas, la naturaleza es muy bonita y todo eso, pero lo que se dice exacta, no lo es mucho. En este ejemplo, el valor 120 se ha superado 9 veces en los últimos 1.000 años, en intervalos que oscilan entre 50 y 170 años.

¿Y ahora qué hacemos?

Estudiar muy bien los datos y tomar un valor lo más representativo posible de su comportamiento. Para este ejemplo simplificado supondremos que, de media, la superación del suceso se ha producido cada 100 años, repito, de media.

Ese tiempo medio entre sucesos independientes es lo que llamamos “periodo de retorno“, y nos permite cuantificar la probabilidad del evento, ya que si estamos suponiendo que el suceso se supera una vez cada 100 años, podemos suponer también que la probabilidad de dicha superación en un año cualquiera será de 1/100.

O sea, que la inversa del periodo de retorno resulta ser la probabilidad anualde superación del suceso. Si tiene un periodo de retorno de 100 años, su probabilidad anual media será de 1/100.

Vale, entendido, el periodo de retorno es el tiempo medio entre sucesos y está relacionado con la probabilidad de cada año, ¿y qué pasará al cabo de 100 años?

Me alegra que me hagas esa pregunta. Para estudiar cómo “se acumula” la probabilidad con el tiempo hay que tener en cuenta dos detalles:

- En los sucesos independientes, la probabilidad de ocurrencia conjunta es el producto de probabilidades.

- Como la ocurrencia sólo se producirá una vez, estudiaremos la probabilidad conjunta de los años en los que no se produce el suceso.

Eso último no lo entiendo, ¿por qué no trabajamos directamente con la probabilidad de superación, de 1/100?

Puede resultar un poco confuso, al principio, pero tiene su lógica. Queremos saber cuál es la probabilidad acumulada al cabo de 100 años… 100 años seguidos en los que no se ha superado el suceso (si lo hubiera hecho ya no serían 100 años seguidos), por tanto, a esos años les corresponde la probabilidad anual de no-superación del suceso.

Vale, ya está claro, te dejo seguir.

Muy amable, sigo entonces, que hay prisa.

Si la probabilidad de superación es del 1% (1/100), la probabilidad de no-superación será del 99% = 0,99

La probabilidad de no-superación de dos (2) años seguidos será: 0,99·0,99 = 0,992 = 0,9801 (98,01%)

Para tres (3) años seguidos será: 0,99·0,99·0,99 = 0,993 = 0,9703 (97,03%)

Y para 100 años será: 0,99100 = 0,366 (36,6%).

Es decir, que la probabilidad de no-superación del suceso en 100 años seguidos será del 36,6%.

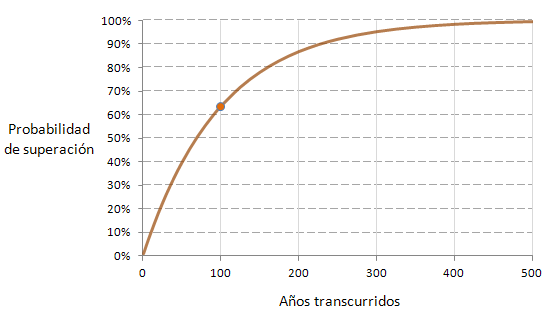

Restando el 100% tendremos la probabilidad de superación, que será de 100% – 36,6% = 63,4%

Por tanto, pasados 100 años, la probabilidad de que se produzca un suceso con un periodo de retorno de 100 años es del 63,4%.

¡¡ Del 63,4% !!, ¿y por qué no del 100%?

Porque, desde el principio hemos dicho que el periodo de retorno de 100 años y la probabilidad anual asociada de 1/100 eran valores medios a partir de los datos disponibles, y no certezas matemáticas exactas (evidentemente, cuanto más elevada sea la probabilidad, más se acercará al periodo de retorno conforme pase el tiempo, pero seguirá siendo una probabilidad).

Entonces, cuando dicen eso de “el periodo de retorno de un terremoto gordo en España es de 100 años y el último fue en 1884, ya debería haber llegado uno gordo“… ¿no es cierto?

No, al menos no desde un punto de vista estadístico. Ese terremoto gordo podría haber llegado hace 50 años, podría producirse mañana o podría tardar todavía 80 años en llegar, y cada opción tendría su probabilidad asociada, que no tiene por qué ser exacta, además.

Pégale un vistazo a la gráfica y compruébalo, la marca corresponde a la probabilidad para 100 años pero la probabilidad para 200 años ni siquiera llega al 90%.

¿Y así calculáis los ingenieros? No lo veo muy fiable, que digamos.

La naturaleza no es fiable, joven padagüan, al menos no a escala humana. La fiabilidad de los cálculos depende de la fiabilidad de los datos de partida y del mayor o menor conocimiento del fenómeno. A mayor información, más podremos “afinar” las predicciones, pero sin olvidar que un fenómeno natural es imposible de predecir al 100%.

Por eso se sigue investigando y recopilando información, y por eso las teorías y normativas se van actualizando con esas observaciones y esos nuevos descubrimientos, porque trabajamos con probabilidades a partir de datos insuficientes y, lo que es peor, asumimos responsabilidades bajo esas probabilidades.

Vale, vale, no te pongas en plan víctima, ya lo he pillado… ¿qué más?

Nada más, por ahora. Me he tomado ciertas licencias y supongo que un estadístico estricto me daría un tirón de orejas (como poco), pero es el precio a pagar por no usar fórmulas, así que yo lo dejaría aquí. ¿Qué tal?, ¿ha quedado más o menos claro?

Psche, más o menos, supongo que tendré que leerlo otra vez. Lo que no entiendo es por qué las noticias sobre estos temas son siempre tan confusas.

Ya, bueno, tendrás que preguntar a los que escriben esas noticias, yo he hecho lo que he podido.